Mens mange browsere integrerer AI-funktioner i deres browsere, er Opera netop blevet den første browser til at integrere lokale AI-modeller. Opera tilføjer eksperimentel understøttelse af over 150 Local Large Language Model (LLM)-varianter fra omkring 50 forskellige familier af modeller til deres Opera One-browser.

Da sprogmodellerne vil være lokale, behøver brugerne ikke at bekymre sig om, at deres data sendes til LLM’s server. Det er en privat og sikker måde at bruge AI på.

For at bruge de lokale LLM-modeller skal du bruge 2-10 GB plads på din computer, afhængigt af den variant du skal bruge. Nogle af de understøttede LLM’er inkluderer Llama fra Meta, Phi-2 fra Microsoft, Gemma fra Google, Vicuna, Mixtral fra Mistral AI osv. Du kan bruge disse sprogmodeller i stedet for Aria AI fra Opera og skifte tilbage til Aria AI, når som helst du vil have.

Funktionen er i øjeblikket kun tilgængelig i udviklerstrømmen af Opera One. Sådan kan du aktivere og bruge de lokale AI-modeller i Opera One Developer.

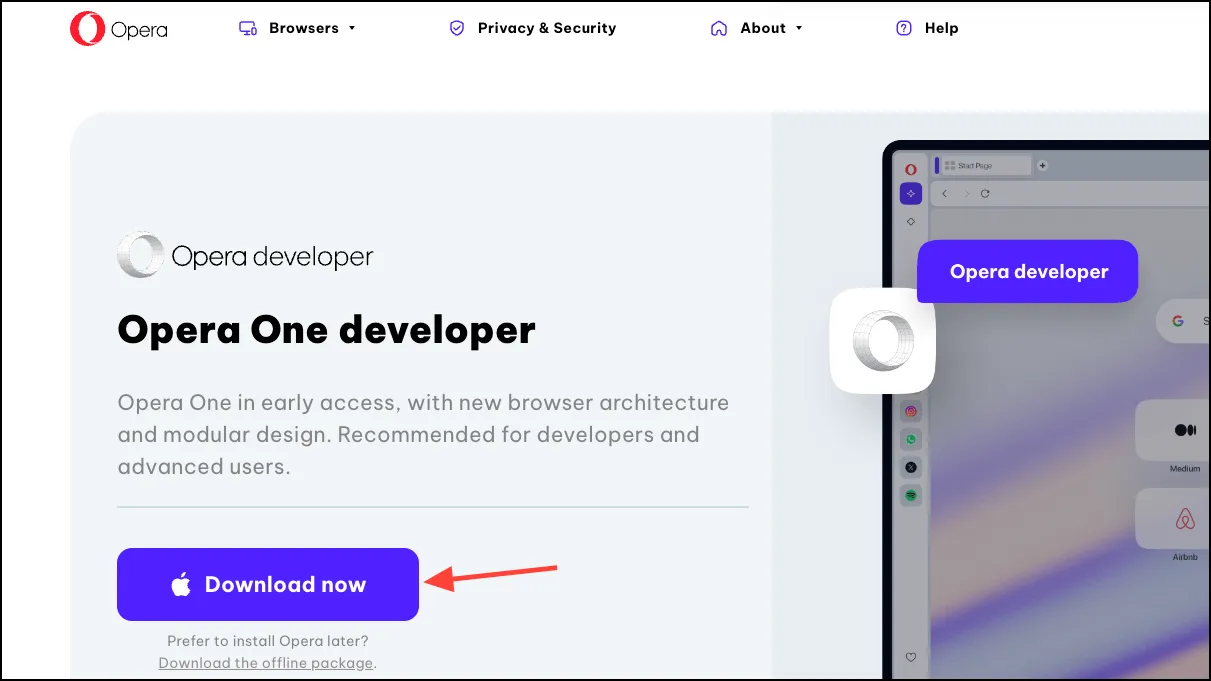

Download Opera One Developer

Hvis du allerede har Opera One Developer, skal du bare springe dette afsnit over og gå direkte videre til at bruge de lokale LLM-modeller.

- Gå til dette link for at downloade Opera One Developer. Rul ned og klik på ‘Download nu’ på Opera One Developer-flisen.

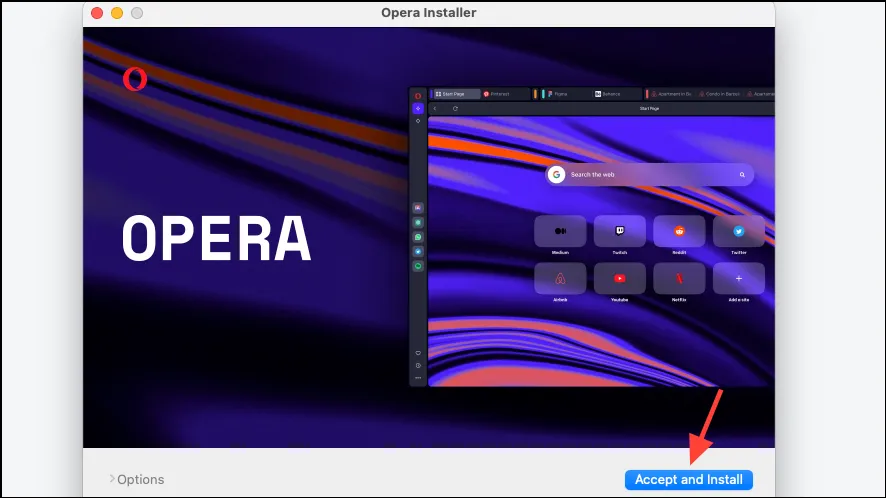

- Åbn filen, når den er downloadet, og kør installationsprogrammet.

- Klik på ‘Accepter og installer’ og følg derefter instruktionerne på din skærm for at installere browseren.

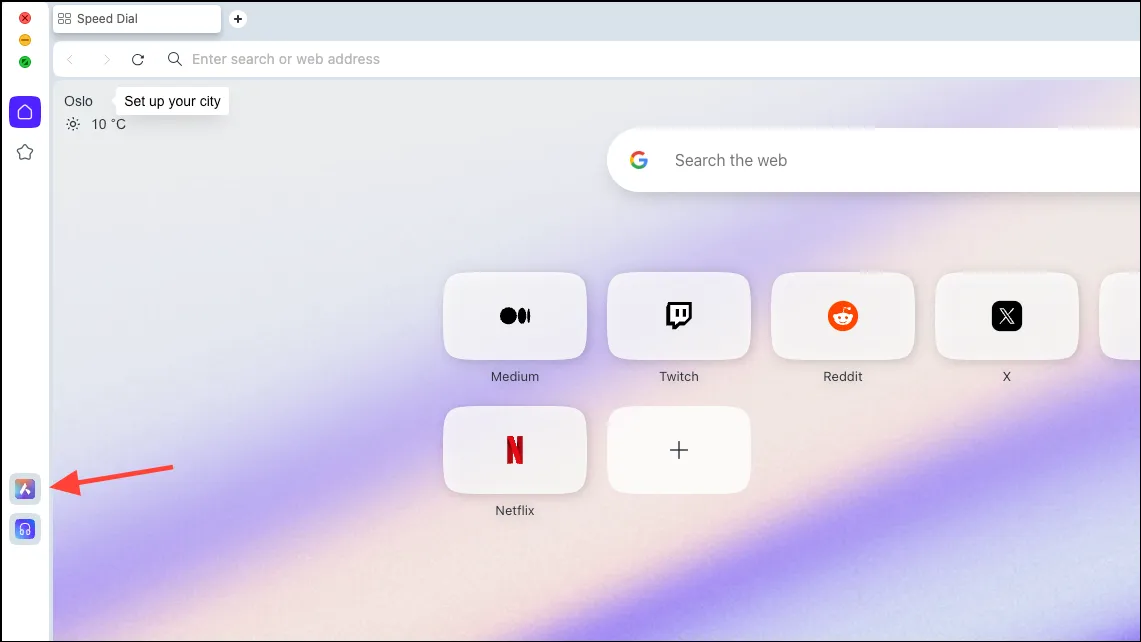

Opsæt lokal AI-model

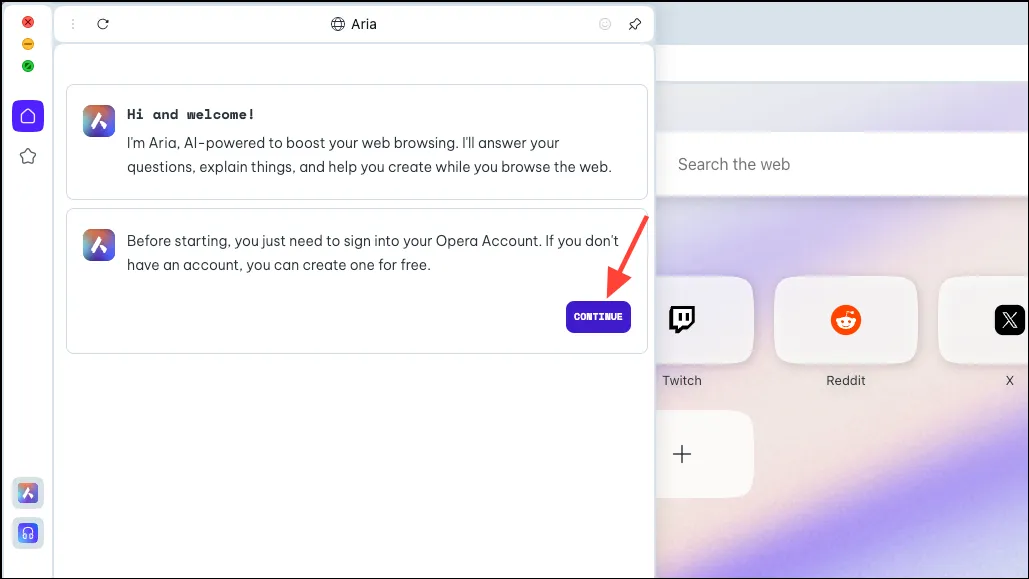

- Når browseren er downloadet, skal du klikke på ‘Aria AI’-ikonet fra venstre sidebjælke.

- Klik på ‘Fortsæt’ for at fortsætte.

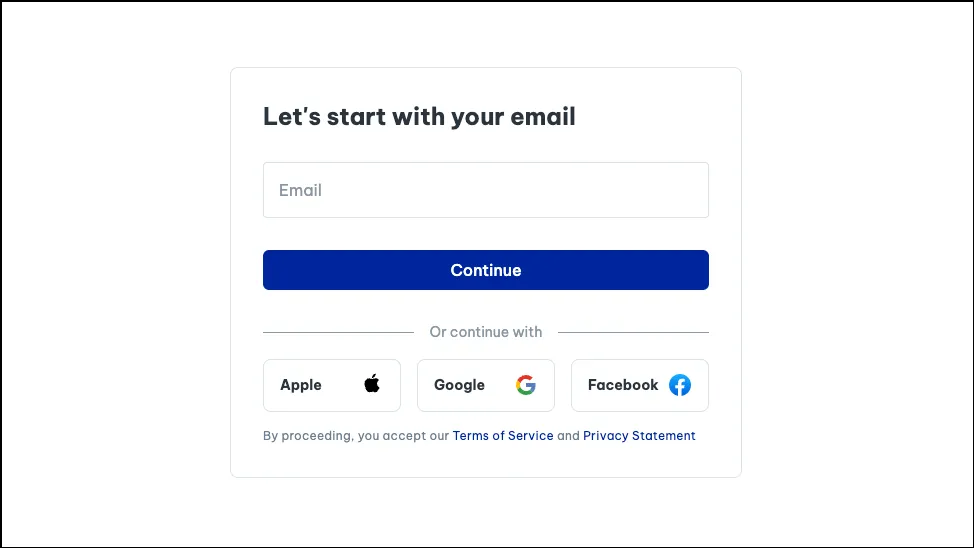

- Hvis du bruger Aria for første gang, skal du tilmelde dig en gratis Opera-konto for at bruge den. Du kan bruge din e-mail eller din Apple-, Facebook- eller Google-konto til at oprette en Opera-konto.

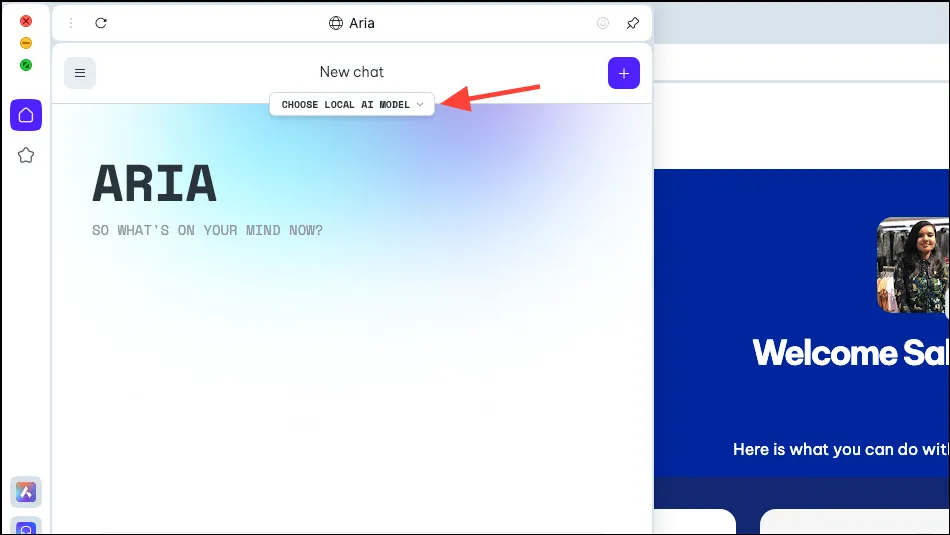

- Når din konto er oprettet, vil du være i stand til at chatte med Aria.

- Nu, i Aria-panelet, vil du se en mulighed, ‘Vælg lokal AI-model’. Klik på den.

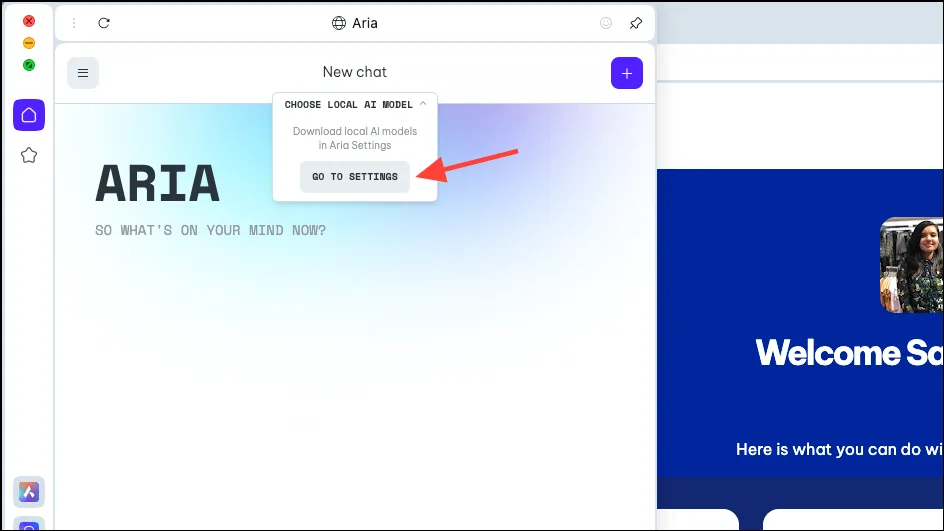

- Vælg ‘Gå til Indstillinger’ fra rullemenuen.

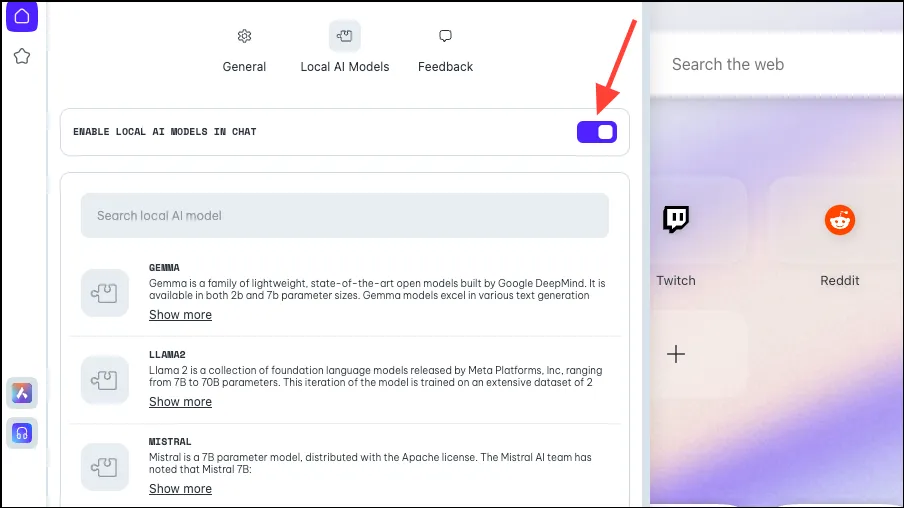

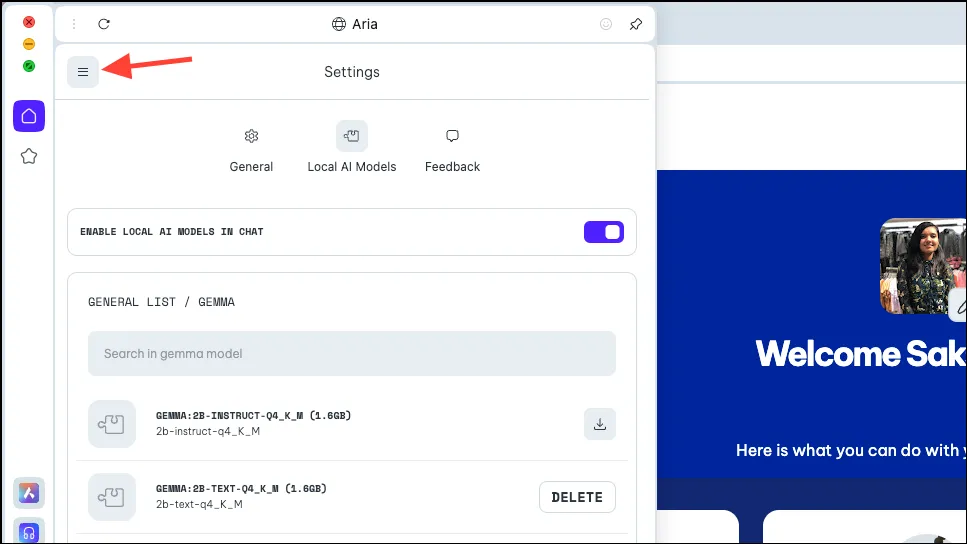

- Sørg for, at omskifteren for ‘Aktiver lokal AI i chats’ er aktiveret.

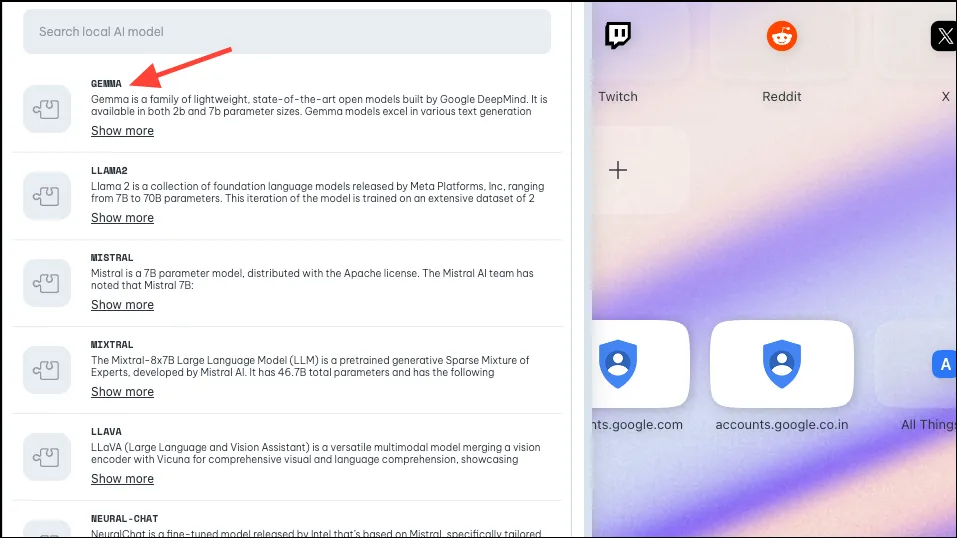

- Vælg derefter den model, du vil downloade til lokal brug, ved enten at klikke eller søge efter den. Som nævnt ovenfor har Opera implementeret support til cirka 50 modelfamilier med forskellige varianter, hvilket bringer det samlede antal op på 150.

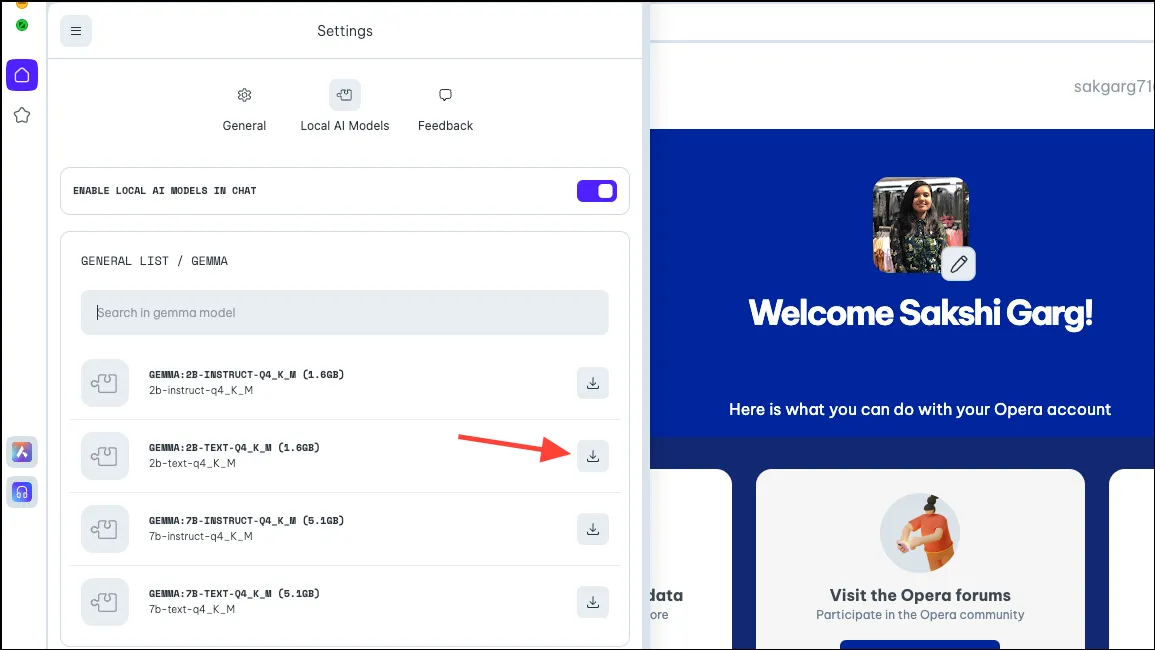

- Så for nogle modeller, når du klikker på nogle af modellerne, som Googles Gemma, får du 4 forskellige varianter. Download den model, du vil bruge. Til denne guide downloader vi Gemmas 2B-tekstmodel. Klik på knappen ‘Download’ til højre. Du kan se den plads, som modellen kræver på din pc, før du downloader den.

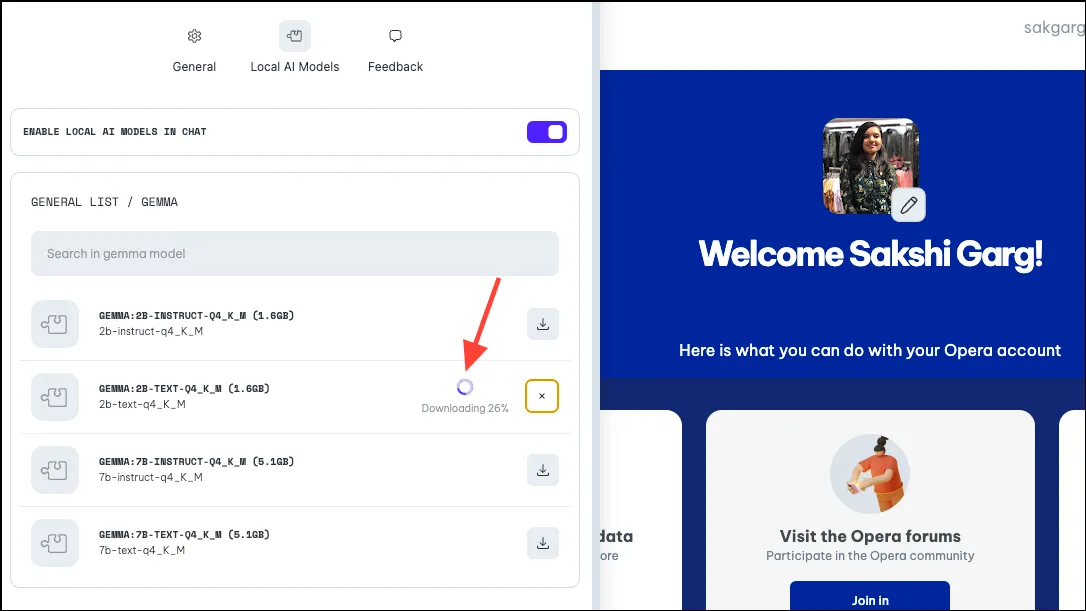

- Downloaden vil tage noget tid, afhængigt af modelstørrelsen og din internetforbindelse. Du kan se forløbet af download ved siden af.

Brug af den lokale AI-model

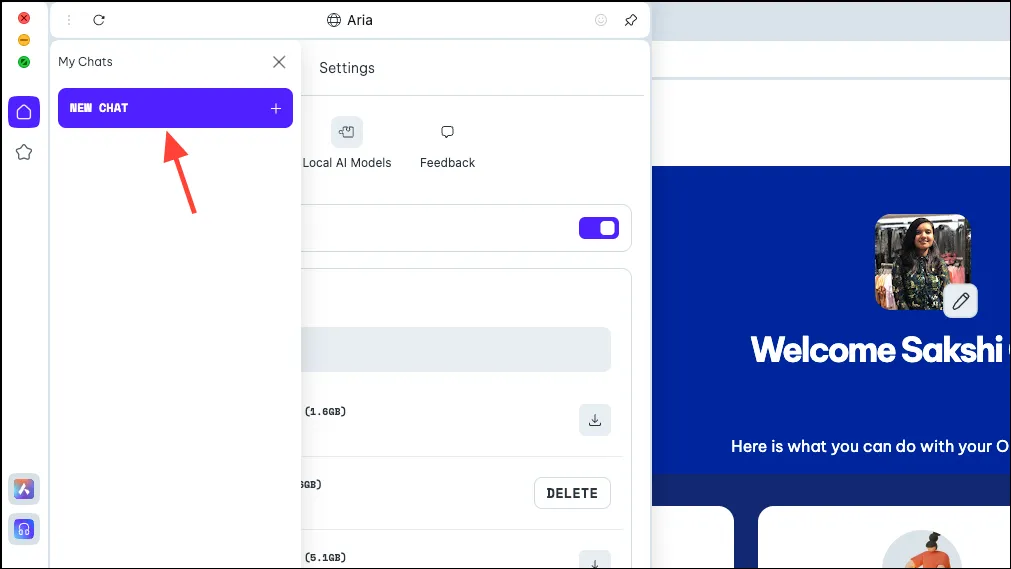

- Når modellen er downloadet, skal du klikke på ‘Menu’-ikonet øverst til venstre i panelet.

- Vælg ‘Ny chat’ i menuen, der vises.

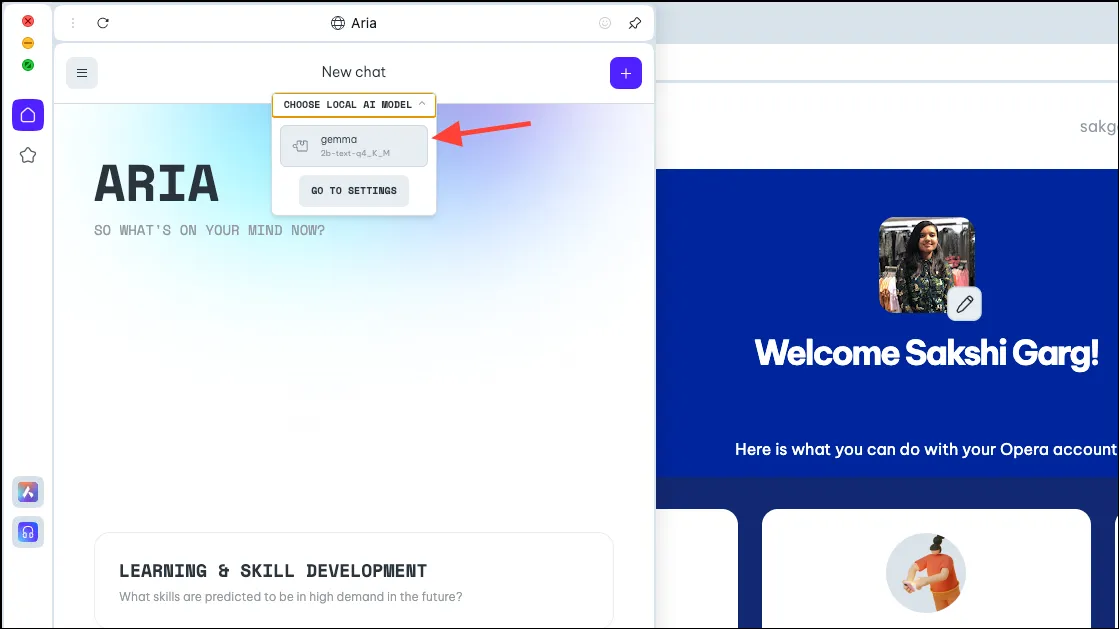

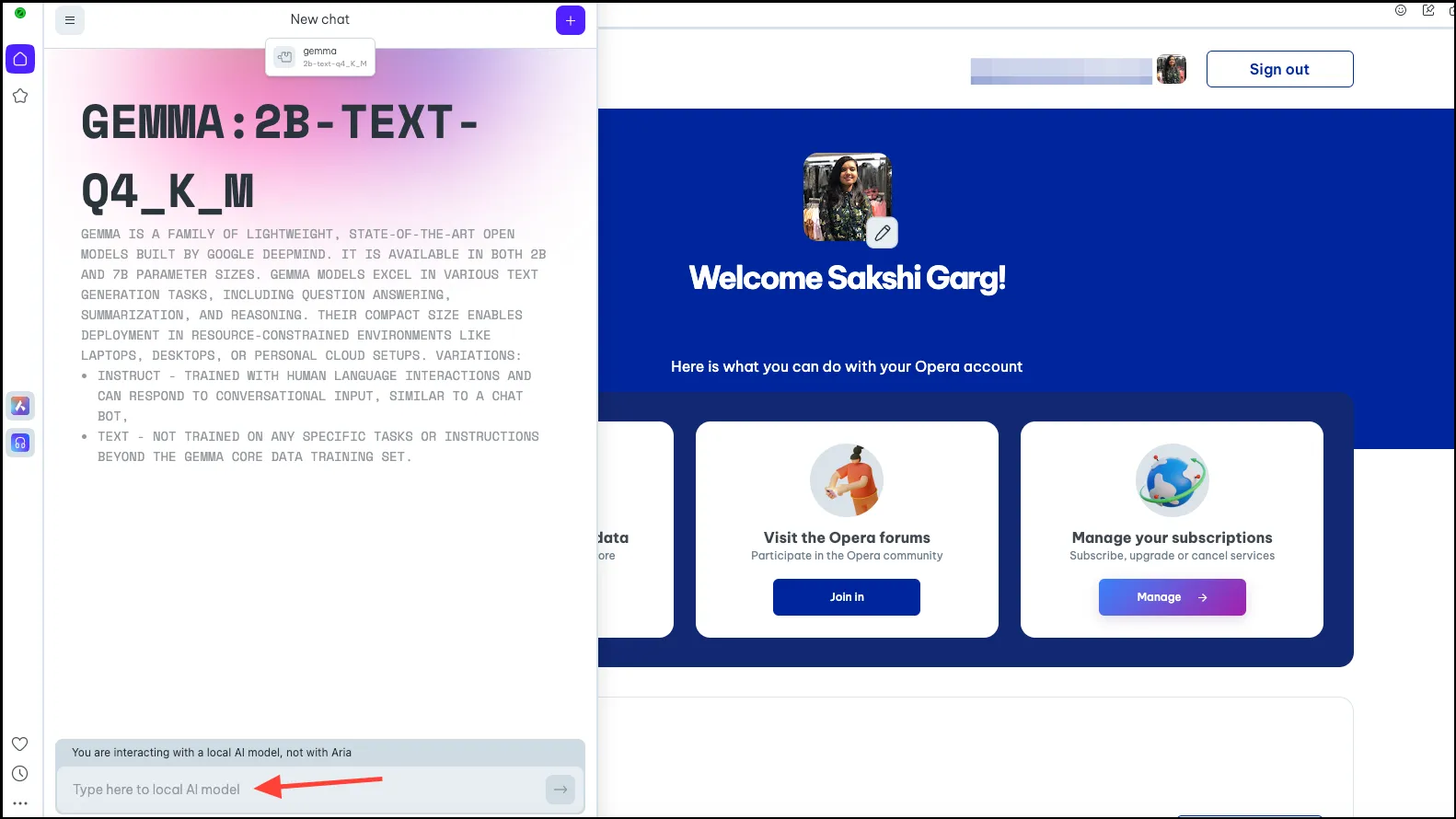

- Igen, klik på valgmuligheden ‘Vælg lokal AI-model’ øverst og vælg den model, du lige har downloadet, Gemma i vores tilfælde, fra rullemenuen.

- Du vil nu blive skiftet til den lokale AI-model efter eget valg. Indtast din prompt i promptlinjen og send den til AI’en for at begynde dine lokale interaktioner.

- Dine chats med den lokale AI-model vil være tilgængelige i chathistorikken, ligesom dine chats med Aria er. Du kan også omdøbe chattene for bedre organisering.

- På samme måde kan du downloade og bruge flere lokale AI-modeller, men husk, at hver enkelt kræver et sted mellem 2-10 GB plads på din computer.

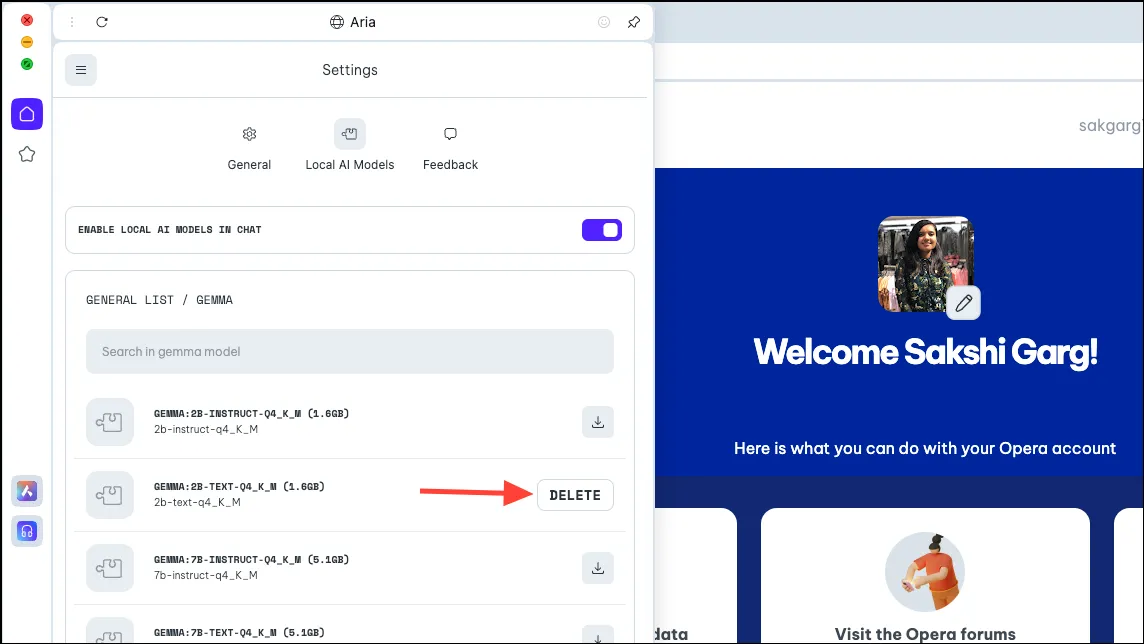

- For at slette modellen fra din pc skal du navigere til de samme indstillinger, hvorfra vi downloadede modellen tidligere, dvs.

Aria>Settings>Local AI Models>[Downloaded Model]. Klik derefter på knappen ‘Slet’.

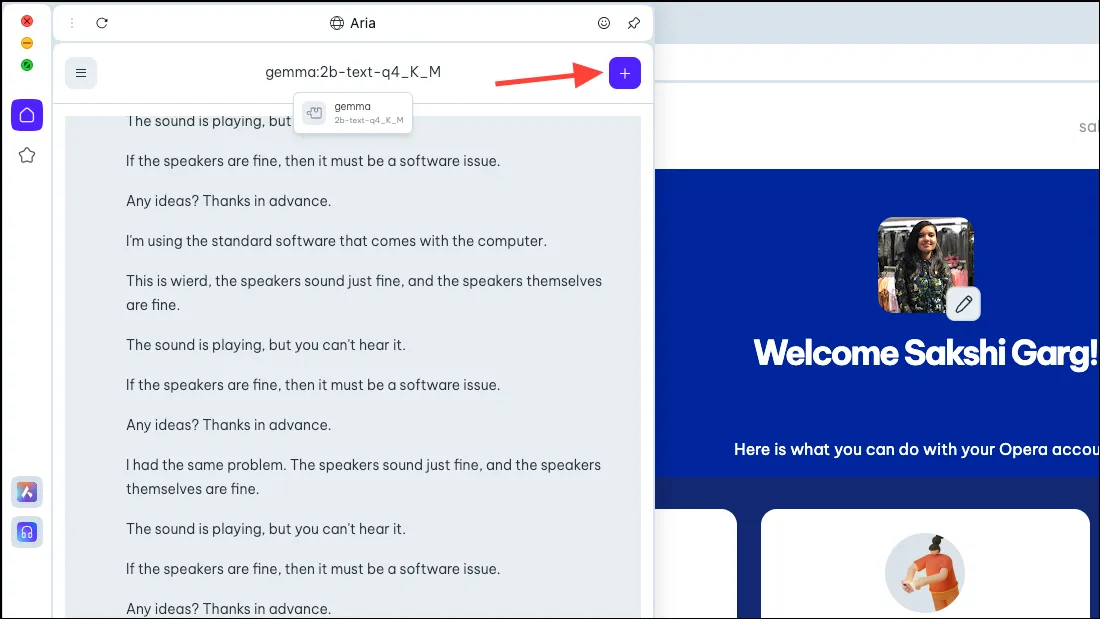

Skift tilbage til Aria

- For at skifte tilbage til Aria skal du blot starte en ny chat med AI. Klik på ‘+’-ikonet i øverste højre hjørne.

- Den nye chat starter med selve Aria.

Det er meget spændende at kunne bruge lokale AI-modeller på Opera One-browseren, og ikke kun ud fra et sikkerheds- og privatlivssynspunkt. Mens det i de tidlige stadier er meget enkelt, er de potentielle fremtidige sager ret spændende. En browser med en lokal AI kan betyde, at den kan bruge dine historiske input med alle dine data; hvor ville det være spændende! Og holdet hos Opera undersøger den mulighed.

Men selv uden fremtidige muligheder er lokale AI’er et godt træk for brugere, der bekymrer sig om deres data og chatter med AI’en, der er gemt på dens servere. Der er nogle fantastiske LLM’er, du kan udforske, såsom Llama til kodning, Phi-2 for fremragende ræsonnementevner og Mixtral til opgaver som tekstgenerering, besvarelse af spørgsmål osv.

Skriv et svar