Hvis du vil køre store sprogmodeller eller LLM’er på din computer, er en af de nemmeste måder at gøre det på gennem Ollama. Ollama er en kraftfuld open source-platform, der tilbyder en tilpasselig og let tilgængelig AI-oplevelse. Det gør det nemt at downloade, installere og interagere med forskellige LLM’er uden at skulle stole på cloud-baserede platforme eller kræve teknisk ekspertise.

Ud over ovenstående fordele er Ollama ret let og opdateres jævnligt, hvilket gør den meget velegnet til at bygge og administrere LLM’er på lokale maskiner. Du behøver således ikke nogen eksterne servere eller komplicerede konfigurationer. Ollama understøtter også flere operativsystemer, herunder Windows, Linux og macOS, samt forskellige Docker-miljøer.

Download og installation af Ollama

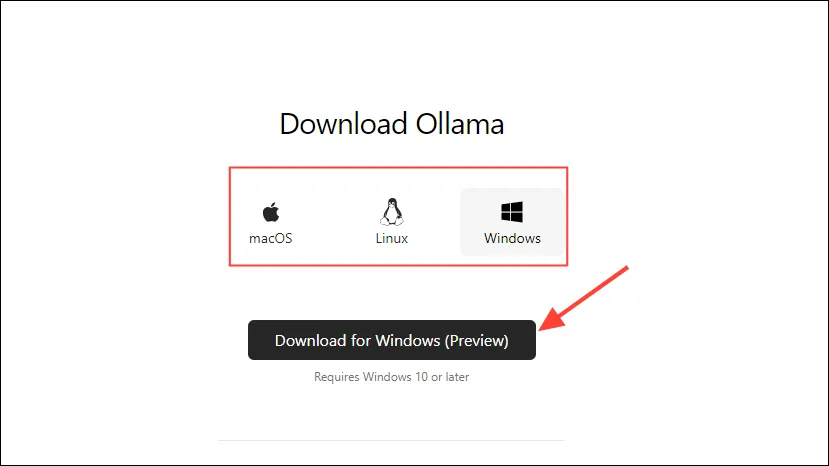

- Besøg først Ollama-downloadsiden og vælg dit OS, før du klikker på knappen ‘Download’.

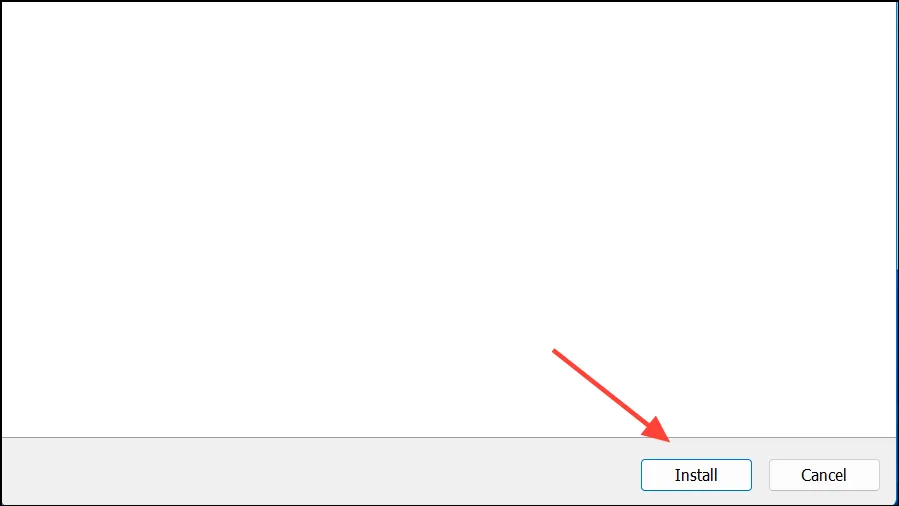

- Når overførslen er fuldført, skal du åbne den og installere den på din maskine. Installationsprogrammet lukker automatisk, når installationen er fuldført.

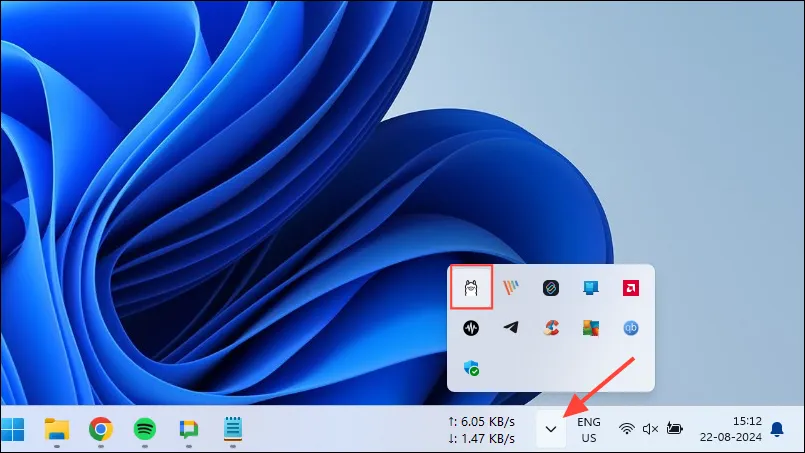

- På Windows kan du kontrollere, om Ollama kører eller ej, ved at klikke på overløbsknappen på proceslinjen for at se skjulte ikoner.

Tilpasning og brug af Ollama

Når Ollama er installeret på din computer, er den første ting, du skal gøre, at ændre, hvor den gemmer sine data. Som standard er lagerplaceringen, C:\Users\%username%\.ollama\modelsmen da AI-modeller kan være ret store, kan dit C-drev hurtigt blive fyldt op. For at gøre det,

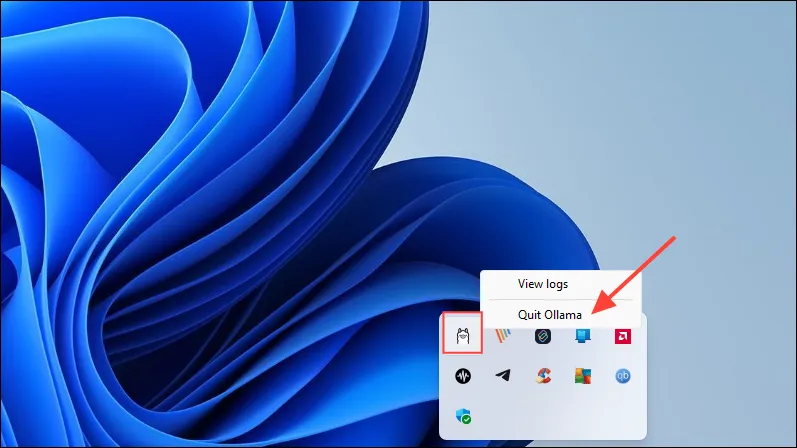

- Først skal du klikke på Ollama-ikonet på proceslinjen og klikke på ‘Afslut Ollama’.

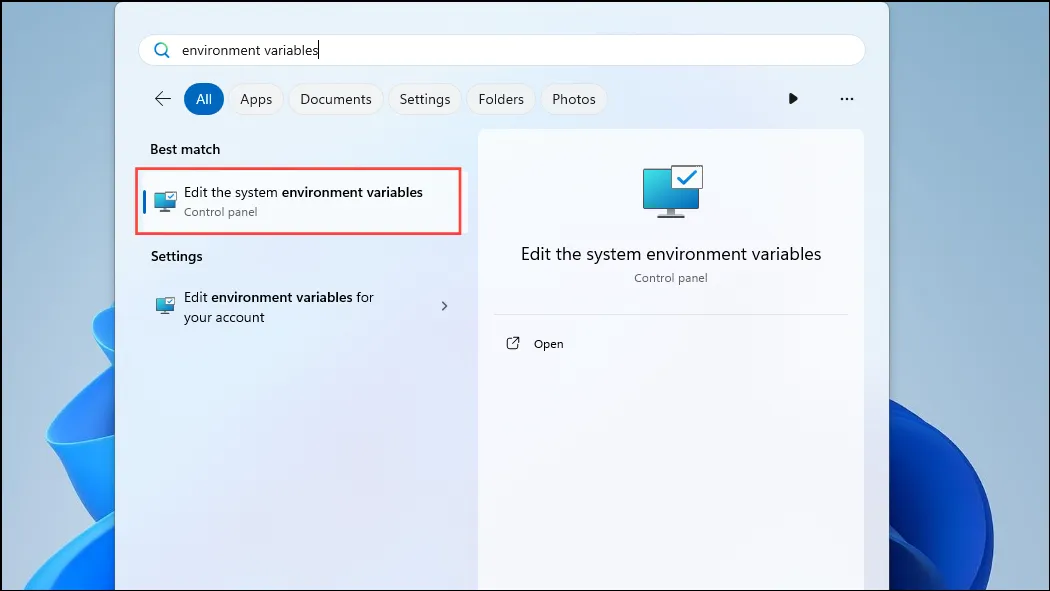

- Når Ollama har afsluttet, skal du åbne Start-menuen, skrive

environment variablesog klikke på ‘Rediger systemmiljøvariablerne’.

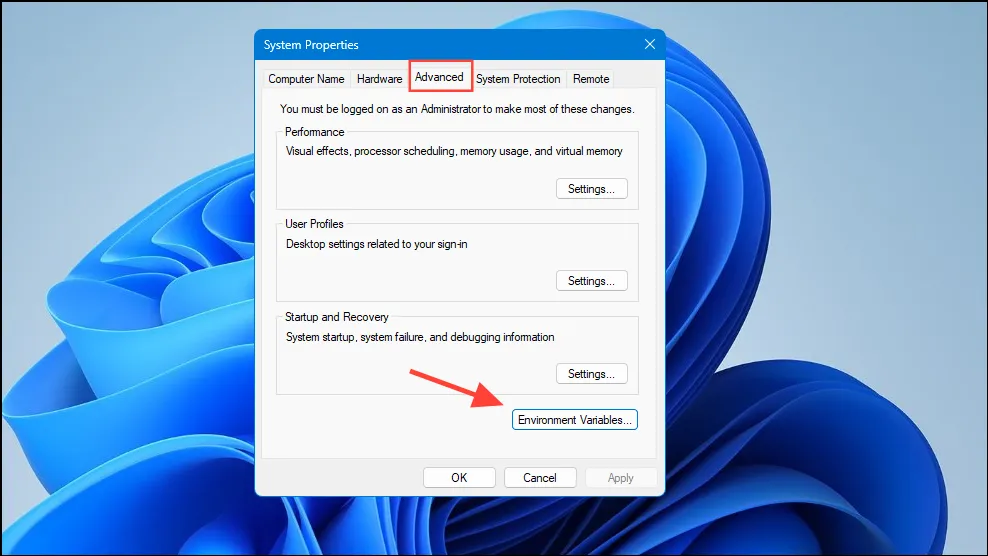

- Når dialogboksen Systemvariable åbnes, skal du klikke på knappen ‘Miljøvariabler’ på fanen ‘Avanceret’.

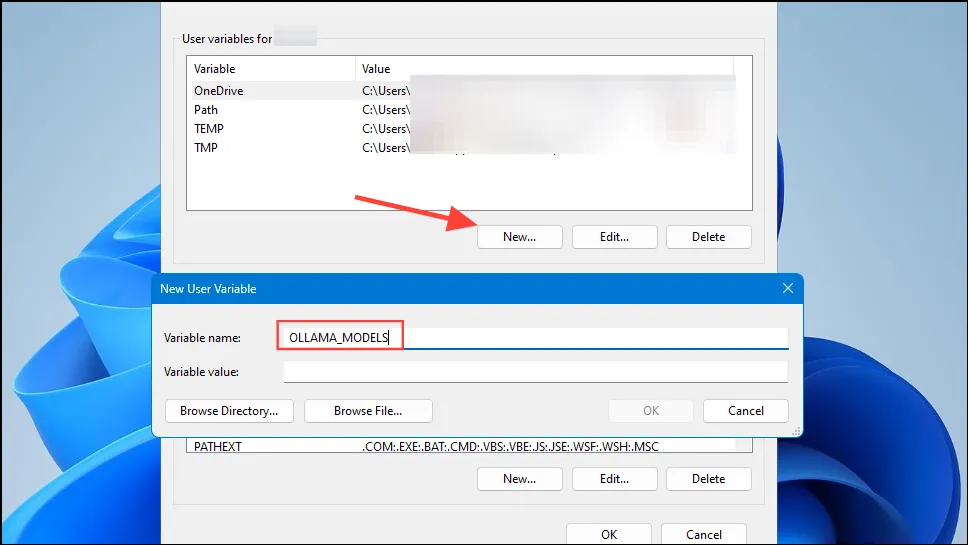

- Klik på knappen ‘Ny’ for din brugerkonto og opret en variabel navngivet

OLLAMA_MODELSi feltet ‘Variabelnavn’.

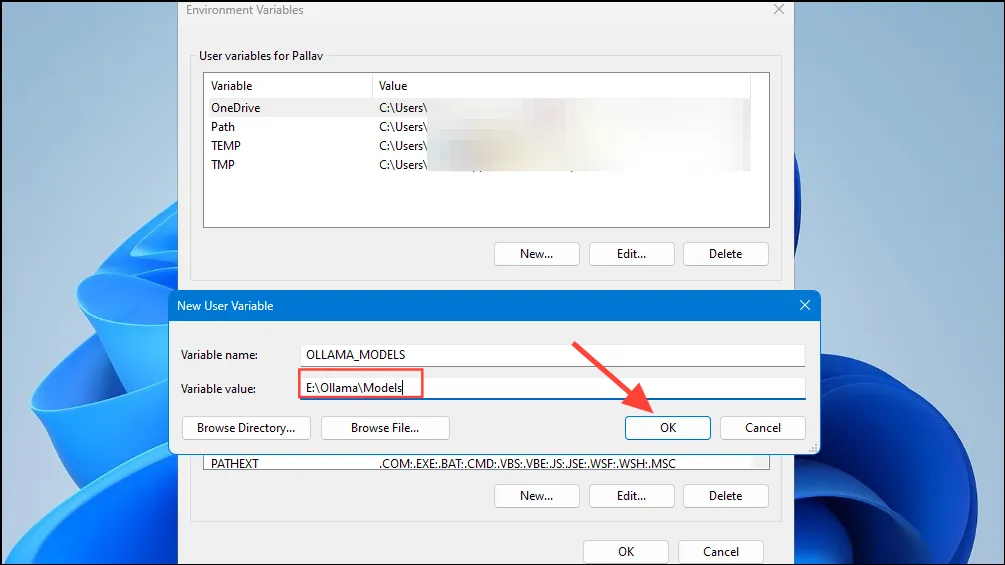

- Indtast derefter placeringen af den mappe, hvor du ønsker, at Ollama skal gemme sine modeller i feltet ‘Variabel værdi’. Klik derefter på knappen ‘OK’, før du starter Ollama fra menuen Start.

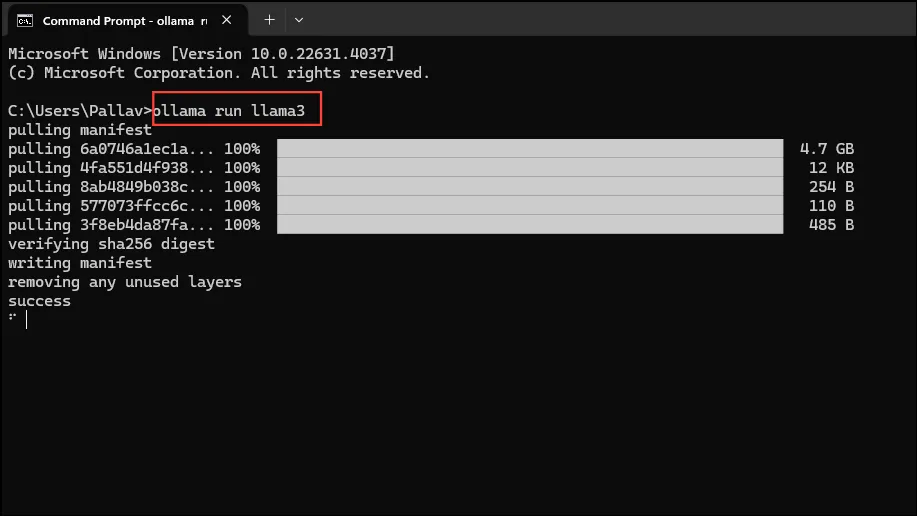

- Nu er du klar til at begynde at bruge Ollama, og du kan gøre dette med Metas Llama 3 8B, den seneste open source AI-model fra virksomheden. For at køre modellen skal du starte en kommandoprompt, Powershell eller Windows Terminal-vindue fra Start-menuen.

- Når kommandopromptvinduet åbnes, skal du skrive

ollama run llama3og trykke på Enter. Modellen er tæt på 5 GB, så det tager tid at downloade den.

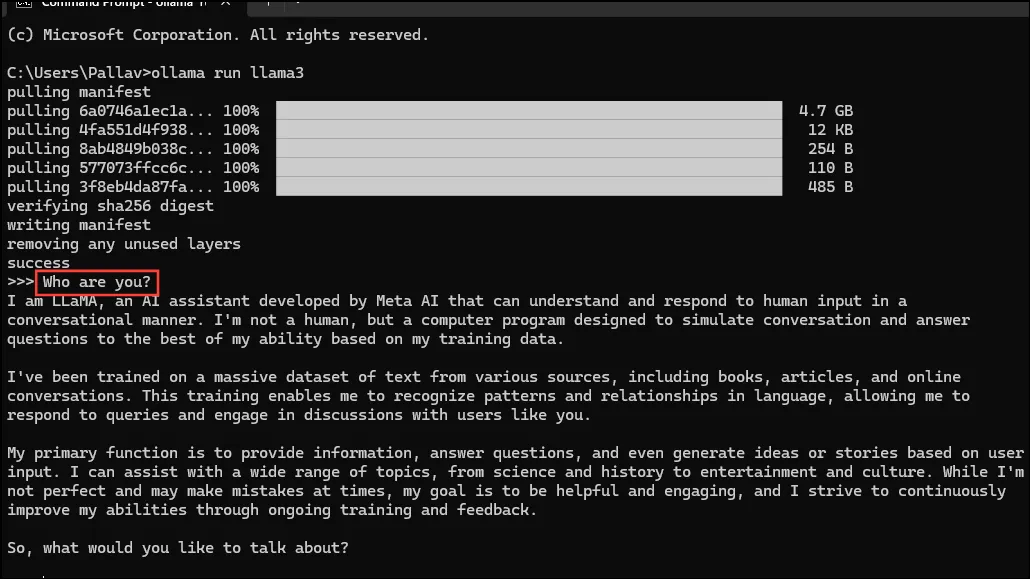

- Når overførslen er fuldført, kan du begynde at bruge Llama 3 8B og tale med den direkte i kommandolinjevinduet. For eksempel kan du spørge modellen

Who are you?og trykke på Enter for at få et svar.

- Nu kan du fortsætte samtalen og stille AI-modellerne spørgsmål om forskellige emner. Bare husk på, at Llama 3 kan lave fejl og hallucinere, så du skal være forsigtig, når du bruger den.

- Du kan også prøve andre modeller ved at besøge Ollama modelbiblioteks side. Derudover er der forskellige kommandoer, som du kan køre for at prøve forskellige funktioner, som Ollama tilbyder.

- Du kan også udføre forskellige handlinger, mens du kører en model, såsom indstilling af sessionsvariabler, visning af modeloplysninger, lagring af en session og mere.

- Ollama lader dig også drage fordel af multimodale AI-modeller til at genkende billeder. For eksempel kan LLava-modellen genkende billeder genereret af DALLE-3. Det kan beskrive billeder i detaljer.

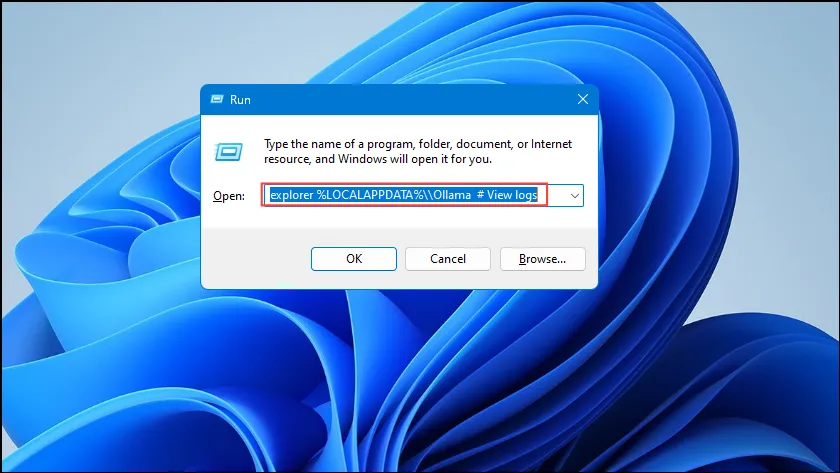

- Hvis du løber ind i fejl, mens du kører Ollama, kan du tjekke logfilerne for at finde ud af, hvad der er problemet. Brug

Win + Rgenvejen til at åbne dialogboksen Kør, og skriv derefterexplorer %LOCALAPPDATA%\\Ollama # View logsi den, før du trykker på Enter.

- Du kan også bruge andre kommandoer som

explorer %LOCALAPPDATA%\\Programs\\Ollamaogexplorer %HOMEPATH%\\.ollamatil at kontrollere binære filer, model og konfigurationslagringsplacering.

Ting at vide

- Ollama registrerer automatisk din GPU for at køre AI-modeller, men i maskiner med flere GPU’er kan den vælge den forkerte. For at undgå dette skal du åbne Nvidia Kontrolpanel og indstille skærmen til ‘Kun Nvidia GPU’.

- Skærmtilstanden er muligvis ikke tilgængelig på alle maskiner og er også fraværende, når du slutter din computer til eksterne skærme.

- På Windows kan du kontrollere, om Ollama bruger den korrekte GPU ved hjælp af Task Manager, som vil vise GPU-brug og fortælle dig, hvilken der bruges.

- Selvom installation af Ollama på macOS og Linux er en smule anderledes end Windows, er processen med at køre LLM’er gennem den ret ens.

Skriv et svar