OpenAI annoncerede for nylig sin GPT-4o-model, en ny flagskibsmodel af motoren, der driver ChatGPT, dens berømte AI-drevne chatbot udgivet første gang i 2022. Denne nyere model tager menneske-computer-interaktion til et helt nyt niveau ved at få det til at virke hurtigere og meget mere naturligt.

I GPT-4o står ‘o’ for ‘omni’, da det kombinerer tekst, billede og lyd til en enkelt model. Selvom der ikke er nogen forbedring i intelligens- og ræsonnementfronten i forhold til GPT-4 Turbo-modellen, er der masser af nye opdateringer. Det er designet til at give hurtigere, mere menneskeligt klingende svar og kan endda simulere følelser. Det er også betydeligt hurtigere til at forstå visuelle og lydinput. I dette dybe dyk vil vi tage et kig på de funktioner, som GPT-4o tilbyder, og hvordan det vil revolutionere den måde, vi interagerer med AI-assistenter på. Så slutt dig til os, og lad os komme i gang!

GPT-4o er væsentligt hurtigere

GPT-4o-modellen tillader ChatGPT at acceptere input i forskellige former, herunder lyd, tekst, billeder eller deres kombinationer. Det kan også give svar i forskellige formater. Det, der dog er mest imponerende ved det, er den hastighed, hvormed det giver dig svar.

Med den nye model tager ChatGPT lige omkring 320 millisekunder eller endnu mindre at reagere på lydinput, hvilket er tæt på den tid, det tager en person at svare i en samtale. Udover dette ligner ydeevnen af GPT-4o GPT-4 Turbo, hvad angår brugen af engelsk eller skrivning af kode.

Den klarer sig også meget bedre, når den reagerer på tekstbaseret input på ikke-engelske sprog, og den er betydeligt billigere i API’en, da den er meget mere effektiv end sin forgænger.

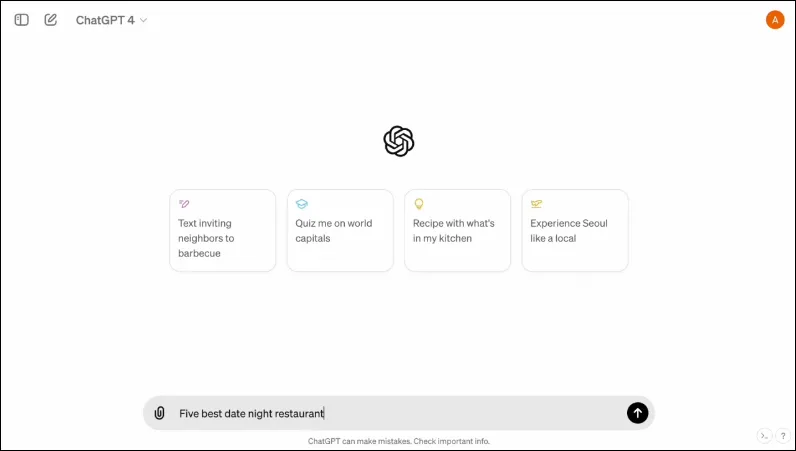

Den har også en ny grænseflade, designet til at gøre interaktion lettere og pænere.

Det er multimodalt

ChatGPTs eksisterende Voice Mode består af tre modeller. Den første tager tekstbaseret input og leverer output i samme format, mens den anden konverterer lydinput til tekst, som tages ind af ChatGPT for at give tekstbaseret output. Den sidste model konverterer tekst til lyd.

Dette design resulterer dog i et tab af information, da modellen ikke kan interagere direkte med lydinput eller nuværende output, der har følelsesmæssige elementer. Med GPT-4o har OpenAI bygget en enkelt multimodal model, der kan forstå forskellige typer input og behandle det nødvendige output direkte.

Den understøtter i øjeblikket 50 sprog og vil også være tilgængelig som en API.

Det kan simulere menneskelige følelser

Da ChatGPT først blev annonceret, var en af de største ulemper ved AI-chatbot for mange mennesker, at den ikke kunne give følelsesmæssige reaktioner. Med GPT-4o kan ChatGPT simulere menneskelige følelser og give passende svar, der integrerer sådanne følelser.

I de demoer, der deles af OpenAI, kan chatbotten ses grine, synge og endda vise sarkasme, når han bliver bedt om det. Dette er ligaer over, hvad enhver anden AI-chatbot kan gøre i øjeblikket og vil gøre brugerinteraktioner meget mere behagelige. Ifølge OpenAI vil den nye model også give ChatGPT mulighed for at registrere brugerens humør og give passende svar baseret på denne information.

Kombineret med evnen til at bruge visuelle input er evnen til at give følelsesmæssige reaktioner en af de mest imponerende funktioner, som den nye model tilbyder.

Den nye model kan gemme en større mængde information

Takket være GPT-4o kan ChatGPT nu bedre forstå billeder, såsom diagrammer og fotos, og også gemme flere oplysninger om brugeren. Dette udmønter sig også i svar, der kan indeholde større stykker tekst, hvilket kan være praktisk i flere tilfælde.

For eksempel kan du bede chatbotten om at oversætte større stykker tekst nu, og det kan hjælpe dig med liveoversættelse. Da det kan bruge visuelle og lydinput sammen med tekstbaserede, kan du bruge det til at indsamle oplysninger fra skærmbilleder, fotos og andre billeder.

Da den kan gemme en større mængde information, uden at brugerne behøver at gentage dem, giver GPT-4o brugere mulighed for at deltage i frem-og-tilbage-samtaler med AI-chatbot. Med større information kan brugerne forvente, at samtalerne bliver mere sofistikerede.

Sikkerhedsforanstaltninger i den nye model

Ligesom de eksisterende GPT-modeller er GPT-4o designet med visse sikkerhedsforanstaltninger for øje for at sikre sikkerheden. Træningsdataene er blevet filtreret, og hvordan modellen opfører sig er blevet forfinet efter træning. OpenAI har også evalueret AI-modellen på tværs af flere parametre, såsom cybersikkerhed og overtalelse, for at undgå uønskede hændelser.

Udover det tog udviklerne hjælp fra over 70 eksperter inden for forskellige områder som misinformation og socialpsykologi for at identificere og afbøde risici, der kunne opstå eller øges med den nye model. De vil også fortsætte med at overvåge brugen af chatbot for fremtidige risici og tage de nødvendige handlinger, når og når det er nødvendigt.

Til at begynde med vil OpenAI kun stille et begrænset udvalg af forudindstillinger til stemmemodeller til rådighed. Den vil også tage højde for brugergivet feedback for at forbedre modellen og sikre fuldstændig sikkerhed.

GPT-4o tilgængelighed

Indtil nu har der været to versioner af ChatGPT tilgængelige – en gratis version, der kører på GPT 3.5 og en betalt version, der kørte på GPT 4.0 og koster $20 pr. måned. Sidstnævnte kan få adgang til en større sprogmodel, så den kan håndtere større mængder data.

GPT-4o vil være tilgængelig for både gratis og betalte brugere og forventes at blive udrullet til enheder i de kommende uger. Den vil være tilgængelig på mobile enheder gennem den eksisterende app, som vil blive opdateret, og en ny macOS desktop-app vil også være tilgængelig udover webversionen for desktop-brugere (Windows-versionen kommer senere i år).

For at skelne mellem gratis og betalte brugere vil OpenAI tilbyde betalte brugere fem gange mere kapacitet end hvad der tilbydes gratis brugere. Når du løber tør for din grænse, vil du blive skiftet tilbage til ChatGPT 3.5.

OpenAI’s meddelelse vedrørende GPT-40 kommer blot én dag før Googles årlige I/O Developer Conference, hvor Google forventes at lave sine egne AI-relaterede meddelelser. OpenAI har også lovet, at flere meddelelser er på vej, så der er ingen tvivl om, at konkurrencen mellem de to rivaler lige er begyndt at spidse til.

Selvom vi ikke ved, hvornår OpenAI vil afsløre flere ændringer til sin AI-model, ved vi, at GPT-4o er på vej til enheder, der kører ChatGPT globalt. Så kryds fingre og vent på, at opdateringen vises på din enhed. Indtil næste gang!

Skriv et svar